Содержание

Оказалось, что это был не DDoS и не атака ИИ

Cloudflare опубликовала технический разбор масштабного инцидента, из-за которого вчера перестали работать ChatGPT, Discord, X, GitLab, сервисы правительства США и даже сам Downdetector.

По словам CEO Cloudflare Мэттью Принса, это был «худший сбой с 2019 года».

Что пошло не так

Проблема возникла не из-за DDoS-атаки, DNS или генеративного ИИ — хотя именно на это компания грешила изначально.

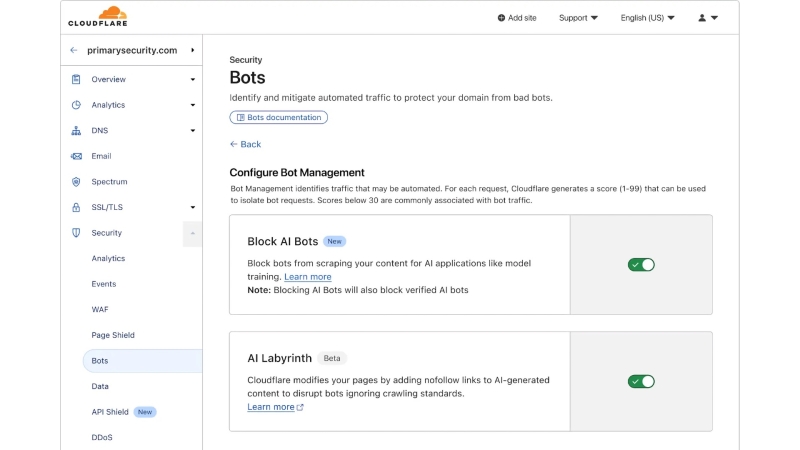

Источник оказался куда менее очевидным: внутренний сбой в системе Bot Management, которая определяет, какие запросы принадлежат людям, а какие — ботам и парсерам.

Система использует ML-модель и большой конфигурационный файл с признаками, по которым определяется бот-трафик. Этот файл регулярно пересчитывается в ClickHouse.

Cloudflare обнаружила, что изменение поведения запросов в ClickHouse привело к появлению множества дублирующихся строк в конфигурации.

Файл стал быстро расти, превысил лимиты памяти и в итоге «уронил» центральный прокси-слой Cloudflare, через который проходит трафик миллионов сайтов.

Клиенты, использующие бот-фильтры, начали получать массу ложных срабатываний — легитимные запросы считались ботами и блокировались. Те, кто не использовал Bot Management, пережили сбой почти незаметно.

Дашборд Cloudflare, демонстрирующий пример управления системой Bot Management

Почему масштаб оказался таким большим

Cloudflare сегодня — один из крупнейших игроков интернет-инфраструктуры:

- по данным самой компании, 20% всех сайтов в мире используют Cloudflare;

- сервисы завязаны на ее CDN, защиту от DDoS, балансировку и маршрутизацию;

- сбой в одном модуле приводит к лавинообразному эффекту.

Фактически, произошла та самая проблема «единой точки отказа», о которой уже давно говорят эксперты сетевой инфраструктуры.

Что Cloudflare планирует изменить

Компания признала, что модель обработки собственных конфигурационных файлов требовала такой же строгой валидации, как пользовательский ввод. Теперь Cloudflare обещает:

- усилить проверку внутренних конфигов перед распространением;

- ввести новые глобальные «kill switch» переключатели для быстрого отключения проблемных подсистем;

- устранить сценарии, при которых отчеты об ошибках могут съедать ресурсы и вызывать деградацию;

- пересмотреть отказоустойчивость всех модулей центрального прокси.

Почему это важно

За последние месяцы это уже третий крупный сбой глобального масштаба: ранее проблемы в Azure и AWS также обрушивали сотни сервисов.

Чем больше интернет завязан на нескольких инфраструктурных компаниях, тем сильнее и заметнее эффект любого сбоя.