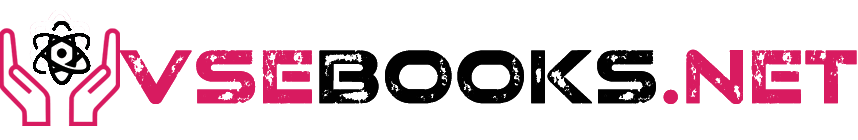

А ведь такой видеозвонок можно совершить и со своими предками…

Character.AI представила разработку, которая может превратить чат с ИИ в видеозвонок — с лицом, мимикой и «живыми» реакциями.

Новый исследовательский проект TalkingMachines превращает обычную картинку и голос в реалистичное видео в духе FaceTime. Пока функция недоступна в приложении, но в будущем может серьёзно изменить формат общения с ИИ.

Как это работает

В основе TalkingMachines — авторегрессионная диффузионная модель на базе Diffusion Transformer (DiT).

Это архитектура, которая умеет постепенно «дорисовывать» картинку из шума. Character.AI удалось адаптировать её под генерацию видео в почти реальном времени, чтобы оно выглядело как обычный видеозвонок.

Модель использует сразу несколько инженерных решений:

- Flow-Matched Diffusion — отвечает за реалистичную пластику движений: от мимики до жестов;

- Audio-Driven Cross Attention — помогает синхронизировать речь и движения губ, считывая паузы, интонации и ритм;

- Sparse Causal Attention — оптимизирует вычисления, чтобы видео не тормозило;

- Asymmetric Distillation — обеспечивает генерацию кадров в стриминговом формате.

Результат — ИИ-собеседник, который не просто говорит, а кивает, моргает и «смотрит» в камеру, реагируя на ваш голос.

Что дальше

Пока это исследовательский прототип, не интегрированный в приложение Character.AI. Но в компании подчеркивают: цель — не просто оживить персонажей, а создать аудиовизуальных цифровых компаньонов, с которыми можно взаимодействовать в реальном времени.

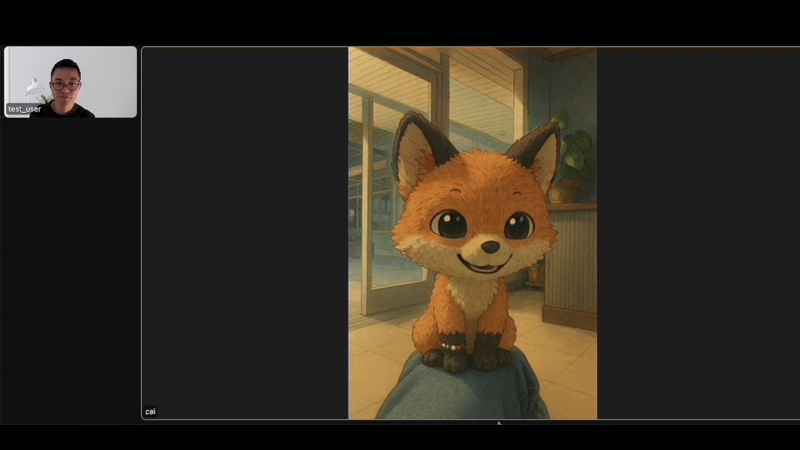

Модель уже умеет работать с разными стилями:

- реалистичные люди,

- аниме-персонажи,

- 3D-аватары.

И всё это — с правдоподобной имитацией «диалогов» в видеоформате.